Ranuras de PCIe y configuraciones

Configuraciones de ranura

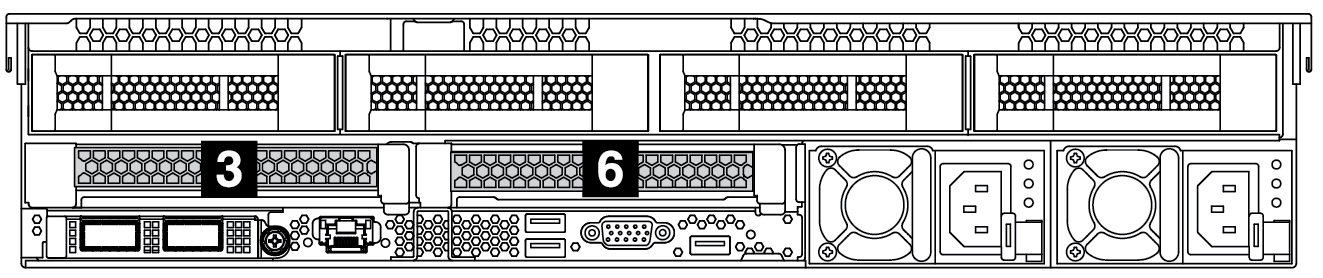

El servidor admite hasta 8 ranuras de PCIe en la parte posterior. Las configuraciones de la ranura PCIe varían según el modelo de servidor.

Para procesadores de la serie AMD EPYC 7002: Habilitar/deshabilitar dispositivo incorporado

Para procesadores de la serie AMD EPYC 7003: Habilitar/deshabilitar dispositivo incorporado

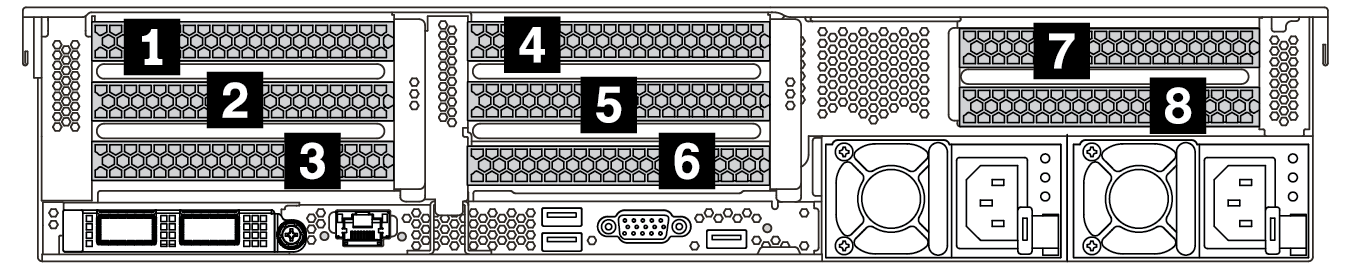

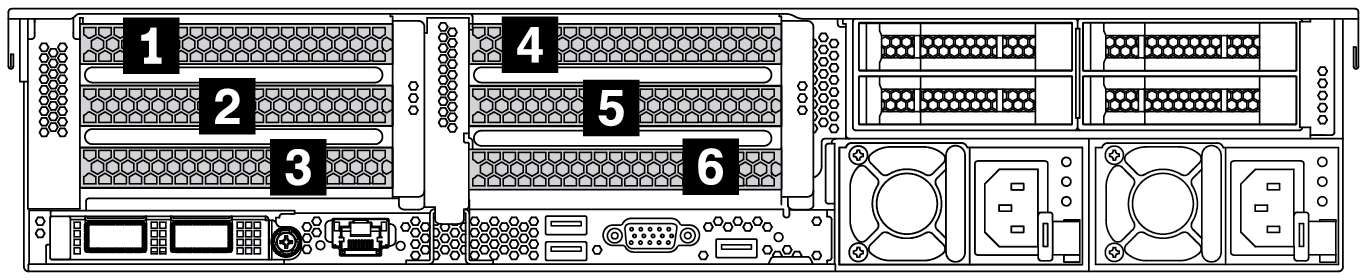

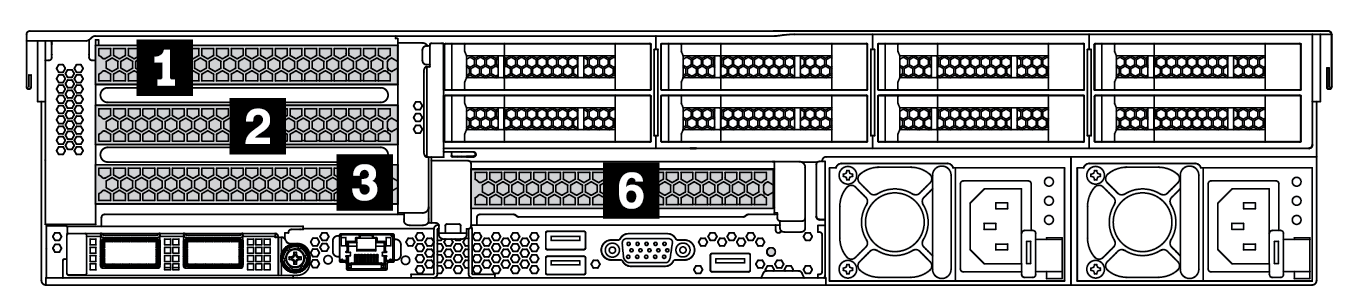

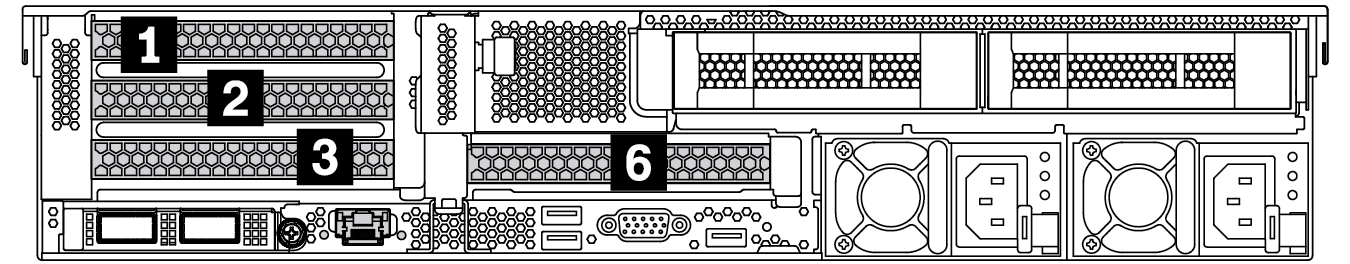

| Vista posterior del servidor | Ranuras de PCIe | ||

|---|---|---|---|

| Ranuras 1 a 3 en la expansión 1:

| Ranuras 4 a 6 en la expansión 2:

| Ranuras 7 a 8 en la expansión 3:

|

| Ranuras 1 a 3 en la expansión 1:

| Ranuras 4 a 6 en la expansión 2:

| NA |

| Ranuras 1 a 3 en la expansión 1:

| Ranura 6 en la tarjeta de extensión 2: x16 | NA |

| Ranuras 1 a 3 en la expansión 1:

| Ranura 6 en la tarjeta de extensión 2: x16 | NA |

| Ranura 3 en la tarjeta de extensión 1: x16 | Ranura 6 en la tarjeta de extensión 2: x16 | NA |

Prioridad de adaptador y ranura PCIe

La siguiente tabla enumera la secuencia de ranuras físicas recomendada para los adaptadores PCIe comunes.

| Adaptadores PCIe | Cantidad máxima | Prioridad de ranura | |

|---|---|---|---|

GPU | Single-wide LPHL (40W/75W) | 8 |

|

Single-wide FHFL (150W) | 3 |

| |

Double-wide FHFL (250W/300W) | 3 |

Nota Para instalar una GPU de doble ancho, se requiere uno de los compartimientos de expansión:

| |

NIC | Xilinx Alveo U25 FPGA | 2 |

|

Xilinx Alveo U50 FPGA | 6 |

| |

Broadcom 57508 100GbE 2-port | 6 |

Nota Broadcom 57454 10/25GbE SFP28 4-port PCIe Ethernet Adapter_Refresh (V2) requiere un soporte de altura completa y deben instalarse en una ranura de altura completa. | |

Broadcom 57454 10/25GbE SFP28 4-port PCIe Ethernet Adapter_Refresh (V2) | |||

Broadcom 57504 10/25GbE SFP28 4-port | |||

Mellanox ConnectX-6 HDR100 IB/100GbE VPI 1-port | |||

Mellanox ConnectX-6 HDR100 IB/100GbE VPI 2-port | |||

Mellanox ConnectX-6 HDR100 IB/200GbE VPI 2-port | |||

Mellanox ConnectX-6 Dx 100GbE 2-port | |||

Intel E810-DA4 10/25GbE SFP28 4-port | |||

NVIDIA ConnectX-7 NDR400 OSFP 1-port PCIe Gen5 Adapter | |||

NVIDIA ConnectX-7 NDR200/200GbE QSFP112 2-port PCIe Gen5 x16 InfiniBand Adapter | |||

Otros | 8 |

Nota Broadcom 57454 10/25GbE SFP28 4-port PCIe Ethernet Adapter requiere un soporte de altura completa y deben instalarse en una ranura de altura completa. | |

Internal SFF RAID/HBA | 430-8i/4350-8i HBA | 4 |

|

530-8i/5350-8i/540-8i/930-8i/940-8i RAID | |||

430-16i/4350-16i/440-16i HBA | 1 |

| |

530-16i/540–16i/930-16i/930–24i/940-16i/940-32i RAID | |||

9350-8i | 4 |

| |

9350-16i | 1 | ||

Internal CFF RAID/HBA/RAID expander | 1 | Parte frontal del chasis | |

External RAID/HBA | 930-8e/940–8e RAID | 4 | NA |

Otros | 8 | ||

NVMe Switch/retimer | Conmutador NVMe | 4 |

|

| Tarjeta de retemporizador | 4 |

Nota Las unidades NVMe CM6-V, CM6-R y CM5-V no se admiten cuando un sistema está configurado con tarjetas retemporizadoras. | |

FC HBA | 8 |

Nota Para obtener más información acerca de los adaptadores HBA FC admitidos, consulte | |

PCIe SSD | 8 |

| |

7mm drive cage | 1 | Ranura 3 o 6 | |

Serial port module | 1 | Ranura 3 o 6 | |

OCP 3.0 | 1 | Ranura OCP | |

Reglas de RAID

Gen3 y Gen4 no pueden instalarse juntas en una tarjeta de expansión.

Los controladores RAID del mismo grupo de generación de PCIe pueden instalarse en una tarjeta de expansión.

Los controladores RAID y HBA se pueden instalar en una tarjeta de expansión.

Los adaptadores RAID/HBA 4350/5350/9350 no se pueden combinar con los siguientes adaptadores en el mismo sistema:

Adaptadores RAID/HBA 430/530/930

Adaptadores RAID/HBA 440/940/540, excepto los adaptadores RAID/HBA 440-8e/440-16e/940-8e externos

El SSD PCIe no admite la función RAID.

El adaptador RAID 940-8i o RAID 940-16i admite modo triple. Cuando el modo triple está habilitado, el servidor admite unidades SAS, SATA y U.3 NVMe al mismo tiempo. Las unidades NVMe están conectadas al controlador a través de un enlace PCIe x1.

NotaPara admitir el modo triple con unidades U.3 NVMe, debe estar habilitado elmodo U.3 x1 para las ranuras de unidad seleccionadas en la placa posterior a través de la GUI web de XCC. De lo contrario, no se pueden detectar las unidades U.3 NVMe. Para obtener más información, consulte La unidad U.3 NVMe se puede detectar en la conexión NVMe, pero no se puede detectar en el modo triple. Los adaptadores HBA 430/440 no admiten la característica de gestión de unidad de autocifrado (SED).

Los controladores RAID 930/9350/940 requieren un supercondensador.

La sobresuscripción se produce cuando el sistema admite 32 unidades NVMe utilizando adaptadores de conmutador NVMe. Para obtener detalles, consulte NVMe drive support.