Netzwerk verkabeln

Mithilfe der Informationen in diesem Abschnitt können Sie die ThinkAgile VX Einheiten mit dem Netzwerk verkabeln.

Logisches Netzwerkdesign für die Implementierung

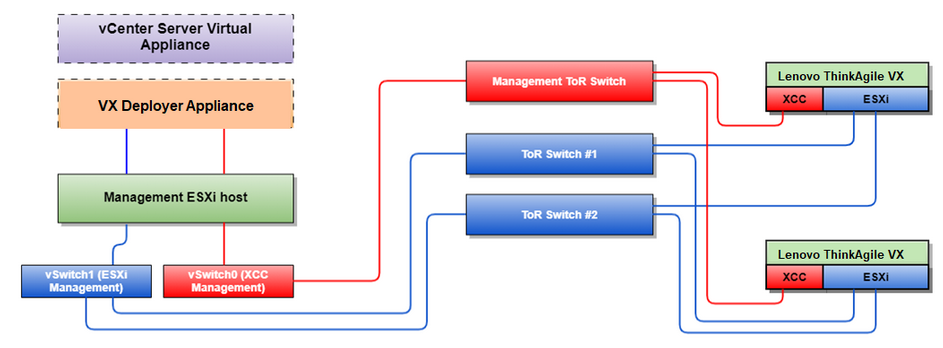

Abbildung 1 zeigt die logische Netzwerkarchitektur für die verschiedenen Komponenten in der vSAN-Clusterimplementierung.

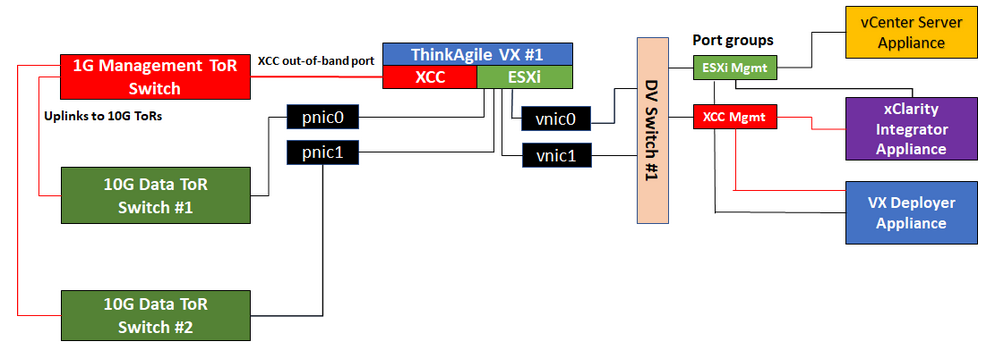

Abbildung 3 zeigt Details zur physischen Verkabelung.

Die VX Deployer Einheit ist eine virtuelle Maschine, die auf dem VMware vSphere Hypervisor (ESXi) ausgeführt werden kann. Im Diagramm ist das Management ESXi host ein designiertes System, auf dem verschiedene Verwaltungseinheiten ausgeführt werden, darunter Lenovo XClarity und vCenter Server Appliance (VCSA).

Bei einer vorinstallierten ThinkAgile VX Einheit ist die virtuelle VX Deployer Einheit vorinstalliert. In diesem Fall wird der VX Deployer auf einer der VX Einheiten ausgeführt und die Clusterimplementierung wird von dort aus ausgeführt.

Jeder VX Server verfügt über dedizierte Verbindungen zu den integrierten 10‑Gb/s-Ethernet-Anschlüssen, die für die Inband-Verwaltung (ESXi Verwaltung, vCenter usw.) verwendet werden.

Die XClarity Controller (XCC) Schnittstellen verfügen über dedizierte Verbindungen für den Außerband-Verwaltungszugriff.

Die virtuelle VX Deployer Einheit benötigt Zugriff auf die ESXi‑ und XCC-Verwaltungsnetzwerke über die virtuellen Switches. Daher sollten die entsprechenden Portgruppen auf dem Switch konfiguriert werden.

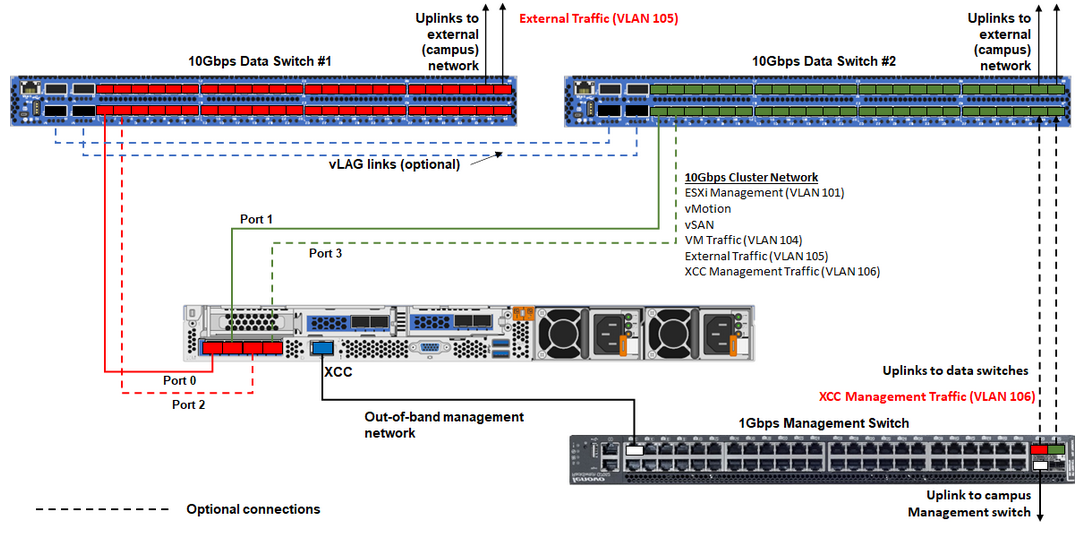

Physische Netzwerkverkabelung

| Netzwerktyp | Erforderlich/optional | Von | Bis |

Inband-Verwaltungsnetzwerk:

| Erforderlich | Anschluss 0 auf NIC | 10‑Gb/s-Daten-Switch 1 |

| Erforderlich | Anschluss 1 auf NIC | 10‑Gb/s-Daten-Switch 2 | |

| Zusätzlich | Anschluss 2 auf NIC | 10‑Gb/s-Daten-Switch 1 | |

| Zusätzlich | Anschluss 3 auf NIC | 10‑Gb/s-Daten-Switch 2 | |

Außerband-Verwaltungsnetzwerk:

| Erforderlich | BMC-Netzwerkanschluss | 1‑Gb/s-Verwaltungs-Switch |

| Daten‑ oder Benutzernetzwerk | Erforderlich | 10‑Gb/s-Daten-Switch 1 und 2 | Externes Netzwerk |

Zu Außerband-Verwaltungsnetzwerk

Das Außerband-Verwaltungsnetzwerk muss sich nicht in einem dedizierten physischen Netzwerk befinden. Es kann als Teil eines größeren Verwaltungsnetzwerks integriert werden.

ThinkAgile VX Deployer und Lenovo XClarity Integrator (LXCI) müssen auf dieses Netzwerk zugreifen können, um mit den XCC-Modulen zu kommunizieren.

Während der ersten Clusterimplementierung und nachfolgenden Vorgänge sollten die XCC-Schnittstellen über dieses Netzwerk für den VX Deployer und XClarity Integrator (LXCI), XClarity Administrator (LXCA) usw. zugänglich sein.

Wenn ein VLAN für das Außerband-Netzwerk verwendet wird, muss das native VLAN auf den physischen Switches für die Außerband-ESXi-Netzwerkanschlüsse konfiguriert werden.

Stellen Sie sicher, dass IPv6 in XCC unter aktiviert ist und im BMC-Netzwerk-VLAN keine IPv6-Datenverkehrsbeschränkungen angewendet werden.

Auf Inband-Netzwerk

Wenn ein VLAN für das Inband-Netzwerk verwendet wird, muss das native VLAN auf den physischen Switches für die Inband-ESXi-Netzwerkanschlüsse konfiguriert werden.

Auf den physischen Switches für die Inband-ESXi-Netzwerkanschlüsse muss eine Maximum Transmission Unit (MTU) von 9.000 konfiguriert werden.

Zu Netzwerkredundanz

Aktiv-Standby-Redundanzmodus:

Wenn nur zwei Anschlüsse (Anschlüsse 0 bis 1) mit den zwei Top-of-Rack-Switches verbunden sind, können Sie den Redundanzmodus als Aktiv-Standby-Modus konfigurieren. Wenn die primäre Verbindung oder der primäre Switch ausfällt, wird die Verbindung übernommen.

Aktiv-Aktiv-Redundanzmodus:

Wenn vier Anschlüsse (Anschlüsse 0 bis 3) mit den zwei Top-of-Rack-Switches verbunden sind, können Sie den Redundanzmodus als Aktiv-Aktiv-Modus konfigurieren. Wenn eine Verbindung ausfällt, sind die anderen Verbindungen weiterhin aktiv. Außerdem werden die Lasten über die Anschlüsse hinweg verteilt.

Optional unterstützen einige Switches ggf. auch vLAG (Virtual Link Aggregation) oder ein ähnliches Protokoll, das die beiden Top-of-Rack-Switches über dedizierte Verbindungen miteinander verbindet und die Switches für die nachgeschalteten Hosts als einzelnen logischen Switch erscheinen lässt. In diesem Fall können die beiden Verbindungen, die vom Host zu den Switches führen, als Aktiv-Aktiv-Verbindungen konfiguriert werden, sodass Sie einen Lastausgleich über die Anschlüsse hinweg sowie eine gesamte 20‑Gb/s-Bandbreite erhalten können.

Verteilte vSwitches

Der VX Deployer erstellt bei der Installation des VX/vSAN-Clusters verteilte vSwitches.

Die verteilten vSwitches bilden im Prinzip einen logischen Switch, der sich über alle Hosts im Cluster erstreckt. Die physischen Anschlüsse auf jedem Host werden zu logischen Uplink-Ports im verteilten vSwitch. Anders als beim Standard-vSwitch bieten verteilte vSwitches erweiterte Konfigurationsoptionen, z. B. Datenverkehrsrichtlinie, Link Aggregation (LACP) und Datenverkehrskonfiguration.

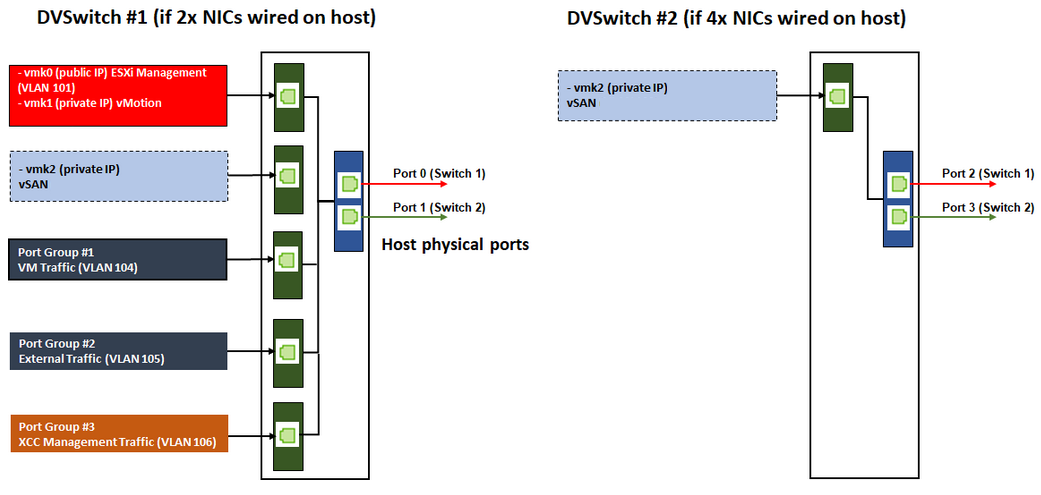

Die Anzahl der erstellten verteilten Switches wird durch die Anzahl der physischen Anschlüsse auf jedem Host bestimmt, der mit Top-of-Rack-Switches verbunden ist:

Wenn nur zwei Anschlüsse an jedem Host verbunden sind, wird ein einzelner verteilter vSwitch erstellt, um alle Datenverkehrstypen zu transportieren, einschließlich ESXi-Verwaltung, VMotion, interner VM, XCC-Verwaltung, vSAN-Speicherdatenverkehr und externer Netzwerkverkehr.

Wenn vier Anschlüsse verbunden sind, werden zwei verteilte vSwitches erstellt. Der vSAN-Speicherdatenverkehr wird vom zweiten verteilten vSwitch transportiert.

Abbildung 4 zeigt das logische Design der verteilten vSwitches an, die vom VX Deployer erstellt werden.